Account maken

Inloggen

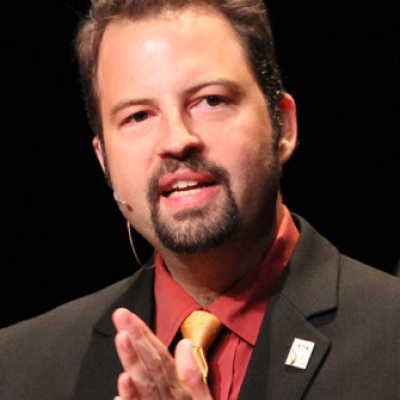

Interview met Paul Debevec, een professor met een hart van een kunstenaar.

Hoe ben je in deze business gerold?

Als kind was ik altijd genteresseerd in fotografie, VFX en wiskunde. Mijn vader was een kernfysicus, dus het was wel duidelijk dat ik op een bepaald moment een PhD moest halen. Werken met technische apparatuur en computers leek iets te zijn wat ouderen doen. Ik had dus veel geluk toen ik een pad vond waarbij ik fotografie, VFX en academisch onderzoek kon combineren. Dus ja... ik denk gewoon door mijn interesse en passie.

Waarom ben je zo geboeid geraakt door Visual Effects?

Ik zag Star Wars voor het eerst in de bioscoop toen ik 6 jaar oud was. En ik heb mijn ouders om toestemming moeten vragen, omdat zij vonden dat ik te jong was. Maar omdat al mijn vrienden er wel naar toe mochten, zeiden ze uiteindelijk dat ik het wel mocht zien. Mits ik op bepaalde momenten die zij uitgekozen hadden mijn ogen dicht deed, anders was de film te intens. En het was een geweldige film.

Wat ik nog veel geweldiger vond, was toen ik op televisie een show zag waarin ze lieten zien hoe de film gemaakt werd. Ik zag die mensen spelen met kleine miniatuur en camera's, optische printers, robots om dingen op afstand te besturen, de bluescreens. Dat zag er gewoonweg fascinerend uit. Op dat moent raakte ik genteresseerd om zelf dingen te doen zoals dat.

Wat voor opleiding heb je gevolgd om je doel te bereiken?

De lessen die ik vroeger het meest kon waarderen waren wiskundige vakken, maar ik vond de tekenles ook erg leuk. Terwijl ik nooit echt goed was in de traditionele manier van kunst en ik geen specifiek talent voor tekenen of schilderen had. In fotograferen ben ik uiteindelijk wel goed geworden, maar iedereen kan tegenwoordig foto's met hun telefoon, dus dat zegt tegenwoordig niet veel.

Op school studeerde ik computer engineering en wiskunde, dus niet iets wat creatief was. Op de universiteit van Michigan waar ik naar toe ging, waren niet heel goede computers op dat moment. Dus ik heb in 1998 een belangrijke les gevolgd genaamd computer vision. Het was een les in een wat oudere discipline die voorkomt uit Robotica, over het analyseren van afbeeldingen. Origineel in de jaren 70 had een robot een videocamera boven op zich en die analyseerde de videobeelden zodat het zich kon voortbewegen zonder dat het de muur raakte. Het moest van een foto begrijpen hoe de wereld er om zich heen uitzag. En als het dingen zag bewegen dan moest het snappen waar ze zouden zijn door te kijken hoe ze van frame naar frame bewogen. Ik vond dit hele interessante onderwerpen en heb hier algoritmes voor geschreven. Ik heb een masteropleiding hierin gedaan en kreeg de hoogste cijfers uit de klas. Als een resultaat hiervan ben ik naar de Universiteit van Californi Berkeley, dichtbij het San Francisco gebied. Ik ben gaan werken met de computer vision groep die een goede computer vision professor had genaamd Jitendra Malik, hij werd mijn onderzoeksadviseur. Ik was in staat om technieken te gebruiken vanuit computer vision om 3d-modellen te creren die ik kon gebruiken bij het computer graphics en dus een brug slaan tussen deze 2 verschillende vakgebieden. Er waren zoveel verschillende coole dingen die je kon doen als je beide vakgebieden goed begreep. Ik was toen n van de weinige mensen die onderdelen van deze vakgebieden samen kon voegen om zo nieuwe tools te ontwikkelen.

Om een voorbeeld te noemen: Het eerste project was architectuur namodellen en renderen vanaf foto's. Dus ik ging foto's maken van gebouwen, lijnen tekenen op de foto's, die de computer zou oplossen op tot 3d modellen. Zo kon ik de foto's projecteren op de 3d geometrie door middel van camera mapping. In het uiteindelijke resultaat kon je rondvliegen door de nagemaakte wereld.

Mijn eerste shortfilm genaamd de The Campanile Movie http://www.pauldebevec.com/Campanile/ is daar het resultaat van.

Je bent onder andere bekend van HDR, was dit je eerste grote doorbraak in je cariere?

Mijn tweede Siggraph paper ging over High Dynamic Range fotografie. De eerste ging over het opbouwen van gebouwen vanuit foto's en de foto's daar weer op projecteren. Toen ik dat project aan het doen was, specifiek voor de Burkley tower, realiseerde ik me dat ik alle foto's wilde nemen met dezelfde belichting, zodat als ik ze weer terug zou gaan projecteren ze consistent zouden zijn met elkaar. Toen realiseerde ik me dat ik dat niet zou kunnen doen als n kant van het gebouw in de zon staat en de andere in de schaduw. Dus ik moest uitvinden hoe ik foto's met verschillende sluitertijden kon combineren met elkaar. Dan ga je je afvragen wat pixelwaardes inhouden en toen ben verschillende sluitertijden gaan samen nemen tot een radiometrische consistente foto, oftewel High Dynamic Range. In 1998 gingen we HDR panorama's gebruiken om een 3d scene te belichten. Toen hadden we zoiets van ja, we zitten in de goede richting. Iedere keer bij een nieuw onderzoek gaan we een richting op, soms is deze doodlopend en proberen we daarna een andere richting. Soms gebeurt het dat twee paden elkaar kruizen, dat heb je dan niet gepland, maar dat zijn wel bijzondere onderzoeken. Voor mij zijn eigenlijk de jaren 1996, 1997 en 1998 de doorbraak, dus niet alleen HDR.

Gezien alle projecten die je gedaan hebt, welke van de projecten was voor jou het meest leuke/interessantste om te doen?

We bouwden in 2001 voor het eerst de Lightstage met kleuren LEDs, om een acteur door een virtuele wereld te belichten zodat we hem later konden samenvoegen met de achtergrond. Het leek ons een leuk project en ik stelde me voor dat er ooit in de toekomst mensen op deze manier films zouden maken. Maar later dacht ik dat ik dit alleen in mijn hoofd verzonnen had dat dit ooit belangrijk zou zijn. Het was gewoon een leuk project voor ons en we moesten er maar niet teveel van verwachten. Later kwam er een film aan die perfect was voor deze techniek, en dat was Gravity, en wat een succes was dat!

Met elke film die zich aandient weet je gewoon niet of het een succes wordt en of de techniek die je erin verwerkt ook meelift. Het is altijd een verrassing als het gebeurd. De Matrix was zo'n project waar geen enkele aanleiding te vinden was die het garandeerde dat het gedragen werd door het grote publiek. Ook op het moment dat wij aan Avatar werkten, wist niemand of het een succes zou worden. Het vertrouwen naar James Cameron toe was er ook niet helemaal. Een film met blauwe wezens was nou niet iets waar je spontaan enthousiast van ging worden. Toch was het een groot cultureel fenomeen geworden.

Gravity was geen uitzondering. We gingen onze Lightstage demonstreren en vergaderden hoe we deze konden inzetten in de film. Het zou een kleine en simpele film worden, maar het tegenovergestelde gebeurde. De film is in samenwerking met de Lightstage een daverend succes geworden. Ik denk dat de eerste kleine Lightstage met gekleurde LEDs mijn favoriete technologie is. Deze heb ik nog steeds en zal ik nooit weg doen.

Ben je niet bang dat als je teveel delegeert dat je dan de leuke dingen niet meer zult doen?

Ja, absoluut! Ik ben ook af en toe jaloers op teamleden die de leuke dingen wel kunnen doen. Hoe je het ook bekijkt, ik heb extreem veel geluk met mijn werk, dat ik zo betrokken kan zijn. En dat ik ook nog eens naar awesome plaatsen zoals FMX kan komen. Ik mag niet klagen.

Er ligt een verwachting dat we elke keer met nieuwe resultaten aan komen zetten, dus we voelen wel de druk dat we iets moeten neerzetten. Maar meestal werken we aan onderwerpen, waar we ook aan zouden werken als we niet betaald zouden worden.

Bij welk project heb je het idee meer geleerd te hebben dan bij andere?

We hebben vorig jaar een project gedaan voor Siggraph. Ik heb daar niets van laten zien tijdens mijn presentatie op het FMX, omdat het niet direct over films ging. Het is een techniek voor het digitaliseren van objecten zoals bijvoorbeeld een bril. Een gesponsord project. Het was de eerste keer dat het ons gelukt was een perfecte reflectie van een bol van licht uit een object te krijgen, wat erg moeilijk is omdat brillen een vreemde reflectie hebben. Al onze andere lightstages met individuele lichten zijn niet handig om naar reflecterende objecten te kijken. Het werkt wel voor de huid omdat er genoeg ongelijkmatigheden op zitten. We moesten iets nieuws ontwerpen. We namen lange sluitertijden, en ontwierpen een halve cirkel die harddraaiend om het object gecontroleerd licht uitstraalde, dit leek te werken.

We belichtten de objecten met Sperical Harmonics (meerdere sphericalmaps met herkenbare patronen). Door enkele algoritmes erop los te laten konden we een diffusemap, specularmap, surface-orientationmap er uithalen, en anisotropische parameters als het gemaakt was uit geborsteld metaal. Dit konden we dan verwerken tot een 3D model.

Tijdens dit project werd ik in het diepe gegooid omdat n van de hoofdonderzoekers een andere baan kreeg. Ik moest het overnemen en kreeg de taak om me er in te verdiepen wat hij gedaan had, en hoe het verder moest. Ik heb hier veel van geleerd omdat ik het letterlijk allemaal zelf moest doen. Ik snap de wiskunde er beter van en ik denk dat we goede resultaten hebben gekregen van het apparaat. Dat was een hele aangename ervaring om uit te vinden dat dit aspect van de Spherical Harmonics je zal vertellen wat de hoek van Anisotropie van het oppervlakte is. Het is een super geeky en nerdy ding, maar ik dacht hierbij echt van: Wow dit is cool!

Zijn er nog projecten waar je op dit moment aan werkt? En kan je ons daar wat meer over vertellen?

Aan het einde van mijn presentatie liet ik een video projector array zien om holografische beelden te projecteren van een acteur. In totaal zijn het 216 projectoren. Het is erg leuk om voor zo'n digitale acteur te staan. Op dit moment kunnen we alleen opgenomen beelden afspelen. Maar we gaan natuurlijk naar de realtime experience. Moet je voorstellen dat je op die manier videogames kunt gaan spelen of een voetbalwedstrijd kunt kijken. Je kan het renderen vanaf de 216 projectoren met de juiste distortions (en nog wat wiskunde) zodat het er goed uitziet als je er omheen loopt. Binnenkort willen we mensen omtoveren tot een digitale versie van zichzelf en ze animeren en besturen zodat het lijkt alsof ze echt reageren op je. En we willen de nieuwe Microsoft Kinect erboven neerzetten zodat iedereen die praat met het karakter getracked wordt, zodat het karakter weet waar iedereen is. En dan kan de hologram mensen aankijken en daarna de volgende. Dat is het mooie hieraan, ze kunnen echt oogcontact maken. Hij kan dus kijken naar n persoon en dan niet kijken naar de andere, om vervolgens te switchen. Dit effect kan je nooit bereiken op een 2D scherm. Ik wil dat het karakter commentaar gaat geven op bijvoorbeeld wat iemand aan heeft.

Dat klinkt allemaal erg spectaculair, maar wat is uiteindelijk je doel van de holografische setup?

Hologrammen zijn op dit moment heel erg in en sinds het Tupac Shakur geholograveerd is, wat gedaan was door Digital Domain, was het toch geen echte hologram. Het is een Pepper's Ghost effect, een 18e eeuwse truc waarbij een afbeelding gereflecteerd wordt op een hoek van 45 graden geplaatst stuk glas. Het ziet er wel goed vanaf een bepaald punt ergens achteraan in het publiek, maar het is niet iets waar je omheen kunt lopen en vanaf verschillende hoeken kunt bekijken. Daarom krijgt ons holografisch display heel veel bekijks als het gaat om deze toepassingen. Helaas zijn het 216 videoprojectoren op een rij en het is lastig om deze allemaal tegelijk te laten draaien. We gebruiken op dit moment 6 verschillende computers. Elke computer bezit 2 infinity kaarten, deze hebben 6 mini display poorten, dus we hebben 12 mini display port uitgangen per computer en deze gaan naar een 3-way port splitter dus we hebben 36 projectoren per computer. De versie die we vorig jaar op Siggraph lieten zien, en dat was maar voor een test, had 72 projectoren op n computer, maar die had 4 grafische kaarten.

We gaan dus werken aan een echte belevenis, al dan niet op entertainment dan wel op functionele wijze. De 18e eeuwse truc moet maar eens opzij stappen, want met de huidige technologie is het gewoon mogelijk om het echt voor elkaar te krijgen.

Heb je dan geen last van distortion met zoveel projectoren?

Nou, door de manier waarop het licht uit de projectoren komt is het licht uiteenlopend. En vanaf daar wordt het ingewikkeld. Het licht van de projectoren achter het scherm lopen uiteen en het scherm refocused het licht niet opnieuw, het blijft uiteen gelopen waardoor het als onscherp wordt ervaren. Dus deze ene projector hier zal een deel van de afbeelding genereren die je ziet, maar een ander deel van de afbeelding die een ander zal zien. De projector moet een erg gebogen versie uitzenden, omdat het beeld vanuit verschillende perspectieven gezien moet worden. Je kunt het misschien inbeelden als een soort inside-out afbeelding. We hebben daar de wiskunde voor uitgevonden. Onze spinning mirror displays hadden zelfs nog ingewikkeldere wiskunde achter zich. Dus we zijn erg goed geworden in hanteren van de idiote distortions die we moeten doen.

Wat is je favoriete kleur?

Goede vraag... Ik denk dat het paars is. Toen wij de lightstage ontwikkelde was LED licht ook in ontwikkeling. Toen op een moment de paarse LED tot onze beschikking kwam, was er heel veel meer mogelijk geworden met de lightstage. Dus ik heb veel te danken aan de paarse kleur 😊

Toen je voor het eerst het idee had om de lightstage te maken, was het altijd om de diffuse, texture, normal, specular en alle verschillende shading aspecten vast te leggen? Of ben je verrast door het resultaat?

De eerste lightstage die we gebouwd hebben projecteerde licht om mensen heen, omdat ik de omgeving om iemand heen wilde projecteren. Ik wilde rondom lichtpanelen zodat we het licht uit foto's konden projecteren op acteurs. Ik kon er niet achter komen hoe we dit betaalbaar konden maken, anders dan dat we met n sluitertijd per foto konden doen. En deze dan achteraf weer samen te voegen met andere sluitertijden om het effect te bereiken. Toen ik bezig was met het eerste lightstage onderzoek, lieten we zien dat je de afbeeldingen samen kon voegen. Maar we lieten ook zien dat als je afbeeldingen hebt van een gezicht, die vanuit elke hoek belicht is, dat je die om kan toveren tot een meer traditioneel 3D model met diffuse kleur, specular kleur en surface orintatie. Het is niet het onderzoek waar ik veel over praat, maar we hebben er veel van geleerd. Ik denk dat ons onderzoek het eerste was die het probleem oploste om een specularmap te krijgen van een gezicht. Om dat te kunnen doen, moet je het gezicht belichten vanuit elke mogelijke hoek. Het gezicht is een soort onduidelijke spiegel van het licht. Hier maken we een opname van. Daarna nemen we het gezicht op met gepolariseerde lenzen en licht (gepolariseerde lenzen kunnen reflecties blokkeren), en het verschil van beide opnames is de specularmap. Dat was n van de dingen die ons genteresseerd hield in dat deel van het project. We zouden d eersten zijn die Spatially Varying Specular Reflectance componenten eruit konden filteren.

Als je aan het werken bent aan een project, speelt het geld een grote rol? Heb je hier altijd genoeg van aangezien je al zoveel goed werk hebt afgeleverd?

We hebben wel wat geld. Ik heb heel veel geluk dat ik werk voor een instituut (de Universiteit) die elk jaar een bepaalde hoeveelheid overheidsfinanciering heeft, dit wordt alleen elk jaar minder. Maar als je kijkt naar andere onderzoeksgroepen, dan hebben wij het niet slecht.

We krijgen een bepaald budget waar we mensen voor inhuren. Dan is dat bedrag op. Maar we willen meer dan alleen van deze overheidsfinanciering te leven. De helft van het geld wat binnenkomt voor onderzoek komt van externe partijen die genteresseerd zijn in ons project. Om al die projectoren te kunnen kopen hebben we een financiering gekregen voor bijna een half miljoen. De geldverstrekker was hier Air Force Office of Scientific Research. Wij kwamen met het voorstel bij hen en beloofden dat we het 3D scherm konden verbeteren. Ons voorstel werd goedgekeurd en we waren enorm blij dat we ook daadwerkelijk aan dit project konden werken. Dus ook wij schrijven onderzoekvoorstellen en we nemen werk aan om al het geld bij elkaar te krijgen.

We hadden eigenlijk wel verwacht dat je wel genoeg geld zou kunnen verdienen als je een bedrijf voor jezelf was begonnen. Heb je hier ooit aan gedacht?

Ik denk dat als we de Universiteit zouden verlaten en onze eigen kantoorruimte zouden kunnen krijgen voor een lage huurprijs, zouden we waarschijnlijk wel in business kunnen blijven door puur opdrachten uit de VFX industrie te doen. Maar ik denk niet dat we ons onderzoeksprogramma tegelijkertijd zouden kunnen ondersteunen. Een onderzoek moet gefinancierd worden, anders kan je geen onderzoek doen. En het is moeilijk om dit voor elkaar te krijgen als je je eigen bedrijf hebt, want het resultaat dat vaak uit een onderzoek komt is vaak niet het resultaat waar je naar opzoek bent.

Een vraag vanuit de community luidde alsvolgt: Het lijkt erop alsof je altijd voor de pragmatische oplossing gaat voor een probleem.

Het praatje wat ik altijd geef over de Lightstage, dat is de versie die laat zien welke stappen allemaal een logisch gevolg waren voor het onderzoek wat we aan het doen waren. Maar tijdens het onderzoek hadden we eigenlijk geen idee wat we nou aan het doen waren. We wisten niet eens of het wel zou gaan werken. Dus heel veel verkeerde afslagen genomen, heel veel lightstages ontworpen en gebouwd die stom waren en niet werkte. Ik heb de presentatie simpel gehouden zodat er een logisch verhaal ontstond. Het verhaal wat je na een project vertelt is altijd anders zijn dan wat er tijdens het project allemaal gebeurd.

Wat vind je ervan als andere mensen jouw technologie gebruiken? Vind je het juist leuk dat dit gebeurt, of heb je zoiets van blijf er vanaf!?

Ik vind het erg leuk, maar het is bijna te vergelijken met je kinderen die voor het eerst naar middelbare school gaan. Je moet je kinderen loslaten, maar het voelt wel alsof je iets kwijtraakt. Je wilt niet dat ze gewond raken of je wilt niet dat ze dingen gaan doen waar je als ouder niet achterstaat.

Toen ik aan de Universiteit met plezier werkte aan mijn scriptie en het onderzoek was in helemaal in mijn nopjes. Het gaf me een overweldigend gevoel dat ik als eerste met deze technieken mocht werken. Er zijn nu genoeg films die deze technieken gebruiken, en ik kan dat zelf toch allemaal niet doen. Hoe geavanceerd mijn technieken ook zullen zijn, je hebt een groot en creatief team nodig om grotere problemen op te lossen. Door samen te werken met de filmindustrie hebben we onze technieken weten te verbeteren. En als je kijkt naar het resultaat wat ze met mijn technieken gedaan hebben bij Spiderman 2, Avatar, en Gravity, dan wil je het wel loslaten 😊

Wat is je visie op de scalability van de lightstage voor kleinere filmmakers?

Ik hoop dat de lightstage als eerste verkleint kan worden zodat deze net zo groot kan zijn als een soundstage. Ik noem het een lightstage omdat hij lijkt op de term soundstage. Daar heb je het geluid onder controle bij een lightstage heb je de controle over het licht. Alle hardware die erin verwerkt zit zoals de LED's zullen in de toekomst goedkoper worden. De rekenkracht van computers zal goedkoper en sneller worden. Ik wil graag dat de kosten naar beneden gaan, zodat dit een techniek wordt waar je voor kan kiezen en dat deze toegankelijk zal zijn voor elke filmmaker. Een filmmaker moet in de toekomst de mogelijkheid hebben om elk gewenst scenario, die hij in zijn hoofd heeft, kunnen uitwerken voor een redelijke prijs.

Denk je dat het mogelijk is om de lightstage op de set te gebruiken?

Nou, we kunnen de lightstage zeker wel naast de set gebruiken. Het is nog niet vaak gebeurd, maar het zal in de toekomst wel vaker gebeuren omdat we nu een verplaatsbare versie in de maak hebben. Tijd krijgen met de acteurs is vaak lastig, maar niet als ze daadwerkelijk aan het filmen zijn. Wanneer je een film aan het maken bent zijn niet alle acteurs altijd tegelijk nodig. Dan zitten ze gewoon een beetje koffie te drinken. Dat is d perfecte tijd om ze in te scannen. Ze zitten dan in de make-up, ze zijn in hun rol en ze zijn beschikbaar. Plus je betaalt natuurlijk voor ze, ook als ze niet acteren voor een camera. We moeten dus een lightstage hebben die in de hoek van de set kan staan, zodat je de acteurs erin kan zetten zodra ze een momentje hebben. Er is ook een hoop interesse in alleen het inscannen van de acteurs. Zelfs als je nog niet weet of je ze gaat gebruiken als digitaal karakter. Want het kan later altijd zijn dat de digitale acteur op bepaalde momenten nodig is.

Wat drijft je om door te gaan, waar haal je je motivatie vandaan?

Ik denk dat ik zeker wel gemotiveerd ben, omdat er nog steeds heel veel dingen zijn die nog gedaan kunnen worden. Ze zeggen tegenwoordig ook wel dat je echt alles met VFX kunt maken in films. Wat misschien zou kunnen kloppen. Als je veel geld en tijd hebt en een team van artists die alle problemen oplossen. Maar een digitaal persoon creren die er niet eng uitziet, doet wat je wil, dat is nog elke keer een groot science/art experiment. Dus als we digitale karakters goed kunnen maken en we ze vol kunnen inzetten voor de filmproducties dat het dan pas een volwassen technologie is. Maar op dit moment zijn we daar nog lang niet en daar wil ik graag mijn steentje nog aan bijdragen om dit mogelijk te maken.

Wil je meer informatie over Paul Debevec, bekijk dan zijn webpagina waar hij veel vertelt over zijn onderzoeken:

http://www.pauldebevec.com/

Geschreven door: Charlotte Vledder en Edwin van het Bolscher.

59163 Views

Blijf op de hoogte!

Ontvang insprirende artikelen, tutorials, tips, nieuws, vacatures en ontwikkelingen in je mailbox.

Over de auteur